本地部署 AI 大模型全流程指南

本地部署 AI 大模型能满足数据隐私需求、提升响应速度,还可针对特定任务定制优化。不过,这一过程涉及硬件、软件、模型等多方面配置,以下为你详细梳理部署流程。

一、前期准备:明确方向与资源储备

(一)需求分析

确定应用场景:思考部署大模型的用途,是用于文本生成,辅助写作、创作故事;还是进行智能问答,打造专属客服;亦或是图像识别,识别特定图像内容等。不同应用场景对模型的能力侧重和资源需求有别。例如,文本生成可能更看重模型对语言流畅性和创造性的把握,图像识别则对算力尤其是 GPU 性能要求更高。

评估资源状况:审视本地硬件资源,查看 GPU 型号与显存大小,像 NVIDIA RTX 30 系列、40 系列显卡常用于模型部署,显存建议 8GB 及以上;内存方面,32GB 及以上能保障模型运行顺畅;存储则需准备足够空间,依据模型大小和数据量,至少预留 500GB 至数 TB 的高速存储,如 NVMe 协议的固态硬盘,以加快数据读写。同时,估算预算,涵盖硬件升级、软件授权(若有)及后续维护成本。

(二)模型选型

调研开源模型:目前开源社区有众多优质模型可供选择,如擅长自然语言处理的 LLaMA 系列,在多种语言任务表现出色;通义千问(Qwen)对中文场景适配度高,语义理解和生成能力强;还有专注于图像生成的 StableDiffusion 等。对比不同模型在自己目标任务上的测评数据、社区活跃度和口碑。

适配硬件条件:若硬件配置有限,可考虑小型轻量化模型,像 Qwen - 1.8B,对显存和内存需求较低,在普通电脑也能运行;若拥有高性能 GPU 和充足内存,像 A100、H100 等专业计算卡,可驾驭更大参数规模的模型,如 LLaMA - 70B,获取更强大的模型能力。

二、环境搭建:构建模型运行基石

(一)硬件配置

确保 GPU 驱动为最新版本,可前往 GPU 厂商官网(如 NVIDIA 官网),依据显卡型号下载对应驱动,保障 GPU 性能充分发挥。同时,安装 CUDA(Compute Unified Device Architecture)和 cuDNN(CUDA Deep Neural Network library),它们是 GPU 加速深度学习计算的关键工具,版本需与 GPU 驱动、深度学习框架适配,具体版本对应关系可参考各软件官方文档。

(二)软件安装

安装深度学习框架:主流框架如 PyTorch 和 TensorFlow 二选一即可。以 PyTorch 为例,可通过官网的安装命令,依据 Python 版本、CUDA 版本选择合适安装指令,在终端执行安装,如pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118(假设 CUDA 版本为 11.8) 。

安装依赖库:根据所选模型和后续部署需求,安装必要依赖库。如使用 Hugging Face 的模型,需安装transformers库,执行pip install transformers;若要部署模型为 Web 服务,可能还需安装Flask、FastAPI等 Web 框架,安装命令为pip install flask或pip install fastapi uvicorn。

三、数据准备:为模型训练注入养分(若需微调)

(一)数据收集

围绕应用场景收集数据,若为医疗问答模型,收集医学文献、病历问答对;若是电商商品描述生成,收集商品详情、已有优质描述等数据。数据来源可以是公开数据集,如 CIFAR - 10(图像识别)、GLUE(自然语言处理),也可自行从行业网站、论坛等渠道采集。

(二)数据清洗与预处理

清洗数据:去除重复数据,防止模型学习冗余信息;剔除错误、无效数据,如乱码文本、损坏图像。同时,处理数据中的噪声,像文本中的错别字、图像中的噪点等。

数据转换:将数据统一格式,文本数据可转换为模型能接受的 token 序列,图像数据调整为固定尺寸、色彩模式等。对于序列数据,进行截断或填充,使其长度一致,方便模型批量处理。

数据标注(若有监督学习需求):如果要对模型进行有监督的微调,需对数据进行标注。如文本分类任务,标注文本所属类别;图像识别任务,标注图像中的目标物体类别、位置等。标注可借助专业标注工具,如 LabelImg(图像标注)、Prodigy(文本标注)。

四、模型部署:让模型 “落地” 运行

(一)模型下载与加载

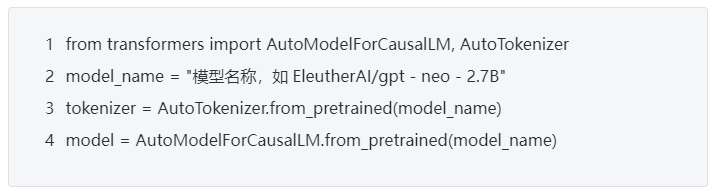

若使用预训练模型,从对应模型仓库下载,如 Hugging Face 平台,利用transformers库的from_pretrained方法加载模型和 tokenizer,示例代码如下:

若模型经过微调训练,加载微调后的权重文件,替换上述代码中的模型加载部分。

(二)推理服务部署

命令行推理(简单测试):部分模型可直接在命令行进行推理测试,如通过 Ollama 工具部署模型后,使用ollama run模型名称命令,即可在命令行输入提示词,获取模型生成结果。

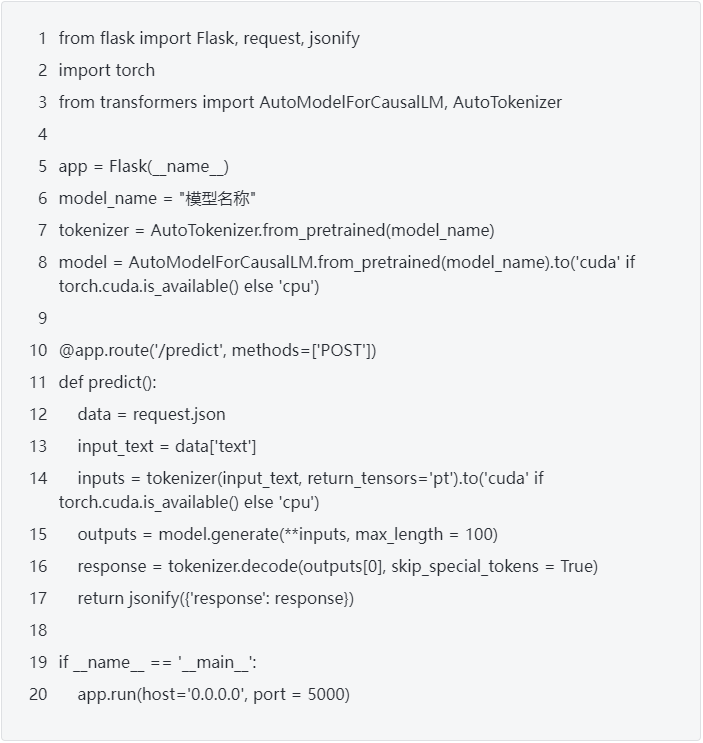

Web 服务部署:利用 Web 框架搭建推理服务,以 Flask 为例,创建一个简单服务代码如下:

运行该代码,启动 Web 服务,可通过发送 HTTP 请求到http://0.0.0.0:5000/predict,携带输入文本,获取模型推理结果。

五、后续优化与维护:保障模型持续高效

(一)性能优化

模型压缩:采用剪枝技术,去除模型中不重要的连接和参数,减少计算量;量化技术将模型参数数据类型从高精度(如 32 位浮点数)转换为低精度(如 8 位整数),降低内存占用,同时不显著影响模型性能。

推理加速:使用推理优化工具,如 TensorRT,它能优化模型推理过程,提升运行速度。将模型转换为 TensorRT 支持的格式,利用其优化策略,在 GPU 上实现高效推理。

(二)监控维护

性能监控:通过日志记录模型推理延迟、吞吐量等性能指标,定期分析。可使用 Prometheus + Grafana 搭建监控系统,实时监测模型运行状态,及时发现性能瓶颈。

模型更新:关注模型社区动态,若有新的预训练权重发布、模型改进,及时更新模型;同时,随着业务数据变化,定期使用新数据微调模型,使其持续适配实际需求。

本地部署 AI 大模型虽有一定技术门槛,但按上述流程逐步推进,合理配置资源、精心处理每个环节,就能成功部署并高效使用大模型,挖掘其在本地环境的最大价值 。